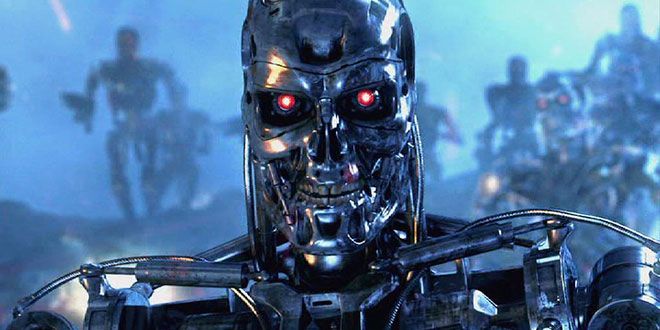

Un tasto rosso per bloccare mestamente l’intelligenza artificiale, prima che questa possa assumere risvolti pericolosi. Uno scenario del tutto afferente ad un film ma che, in fondo, potrebbe pure trovare una mera applicazione pratica, giacché Google pare stia studiando un metodo sicuro per <<staccare la spina>> alle intelligenze artificiali qualora quest’ultime diventino incontrollabili. Il rimando va chiaramente al grande schermo e, in particolare, a celebri pellicole come <<Terminator>>, eppure la paura di situazioni apocalittiche in pieno stile <<cinematografico>> sembra esser balenata nelle menti del colosso di Mountain View. La riprova di tutto ciò può esser letta nel lavoro orchestrato dai ricercatori londinesi di DeepMind, il laboratorio di ricerche specializzato in intelligenza artificiale acquisito nel 2014 da Google per un totale di 500 milioni di euro: l’azienda pare stia infatti collaborando con gli scienziati dell’Università di Oxford su un metodo finalizzato al blocco dei cosiddetti <<agenti IA>>, onde evitare che questi diventino padroni di se stessi fuoriuscendo conseguentemente dal controllo imposto dall’essere umano.

Chiacchiericci che trovano invero il loro inverarsi all’interno di un documento in formato PDF pubblicato sul sito del <<Machine Intelligence Research Institute>> (MIRI) e intitolato, guarda caso, <<Safely Interruptible Agents>>. Il pensiero dei ricercatori può esser letto nel file di cui qualche riga addietro, con annessa la paura che qualcosa possa andare per il verso sbagliato, ribaltando le barriere protettive umane: secondo quanto ribadito in modo netto ed inequivocabile, è piuttosto improbabile che l’intelligenze artificiali si comportino sempre <<in modo ottimale>>, indi per cui potrebbe essere necessario <<premere un grosso pulsante rosso che impedisca all’agente d’intelligenza artificiale di continuare a porre in essere una conseguenza nociva di azioni, così da riportarlo in una situazione più sicura>>, si legge testualmente.

I ricercatori hanno così creato un framework che permette all’operatore umano di stoppare mestamente il funzionamento dell’intelligenza artificiale, tenendo a mente la possibilità – comunque da preventivare – che l’agente IA possa imparare ad impedire il detto blocco. Il framework messo a punto da DeepMind permetterà quindi di far credere all’agente che l’auto-spegnimento sia il miglior comportamento da seguire. Alcuni algoritmi impiegati oggi e conosciuti sotto l’appellativo di <<Q-learning>> possono esser spenti dagli operatori umani, mentre altri (quali <<Sarsa>> ad esempio) non lo sono, sebbene possano esser modificati facilmente cosicché diventino sicuri.

Bisogna comunque tenere a mente che non esistono ad oggi intelligenze artificiali così evolute e tali da metter in pericolo il genere umano, sulla scorta di <<Skynet>> di Terminator, eppure il progresso del detto settore è esponenziale e quindi è difficile, ad oggi, capire quando l’umanità avrà bisogno di premere il fatidico tasto rosso. Secondo il Future of Humanity Institute, le macchine diventeranno più intelligenti dell’uomo entro i prossimi cento anni, ed è per questo che una via di fuga dev’esser già in studio prima che queste possano prendere il controllo e ribellarsi contro i propri creatori.

via